- Главная

- >

- Роботы с искусственным интеллектом

- >

- Робот-официант

Робот-официант

Системы искусственного интеллекта стали довольно хорошими, к этому моменту, в понимании нас, когда мы говорим с ним. То есть, они довольно хорошо понимают, что означают слова, которые мы говорим. К сожалению, для AI, часто в разговорах между людьми мы говорим вещи, которые мы не ожидаем, что другой человек будет воспринимать буквально, вместо этого полагаясь на них, чтобы сделать вывод о наших намерениях, которые могут значительно отличаться от того, что будут предлагать точные слова, которые мы используем. Например, возьмите вопрос “ " вы знаете, который час?"Большинство из нас ответило бы на это, сообщив, сколько сейчас времени, но это не то, что задает вопрос. Если вы на самом деле знаете время, строго говоря, простое “Да, я” было бы правильным ответом. Вы можете подумать, что " вы можете сказать мне, который час?"это аналогичный вопрос, но буквально, он спрашивает, есть ли у вас возможность связать время через речь, поэтому правильный ответ будет “да, я могу”, знаете ли вы, сколько времени или нет.

Это может показаться педантичным, но понимание того, какую информацию мы ожидаем получить, когда мы задаем некоторые вопросы, совершенно не очевидно для систем ИИ или роботов. Эти косвенные речевые акты или ISA являются предметом статьи, представленной в прошлом месяце на Международной конференции ACM / IEEE по взаимодействию с человеческим роботом, и она включает в себя одну из самых интересных бесед между человеком и роботом, которые я когда-либо видел

Одна вещь, которая затрудняет человеко-машинные разговоры, заключается в том, что люди склонны путать вещи, будучи слишком вежливыми. Мы часто рассматриваем вещи как запросы, когда мы подразумеваем, что они являются прямыми командами. Например, в ресторане было бы намного проще, если бы люди надежно сказали «Принесите мне x», когда они захотят x, но многие люди считают это грубым и вместо этого путают вещи с таким языком, как «Можете ли вы принести me x? »или« Если бы вы могли принести мне x, это было бы здорово ». Для робота, который последовательно интерпретирует ISA буквально, это может привести к серьезной путанице.

Теперь можно смягчить путаницу, которую ISA вызывают жестким кодированием в переводах между тем, что говорят люди, и тем, что мы действительно имеем в виду. Я полагаю, что большинство диалоговых агентов (Alexa, Google Assistant, Siri) делают это, потому что они, похоже, не различают: «Можете ли вы сделать x» и «Do x». Я потратил немного времени на возиться с моим собственным помощником Google, чтобы попытаться найти ситуацию, в которой я мог бы заставить ее сделать эту дифференциацию; лучшее, что я мог сделать, это то, что он будет считаться до 10, если я попрошу его: «Можете ли вы подсчитать до 10?», но если бы я спросил его: «Можете ли вы подсчитать до 1000», он по существу сказал, что он может это сделать, но это займет очень долго, так что это не так, и вместо этого я должен выбрать меньшее число.

Исследователи также предполагают, однако, что даже если люди знают, что избегание ISAs является наиболее эффективным способом общения с роботом, воспринимаемая его невежливость все еще может затруднить в некоторых сценариях. В любом случае, разве мы не хотим, чтобы роботы научились взаимодействовать с нами, а не наоборот?

Похожие статьи:

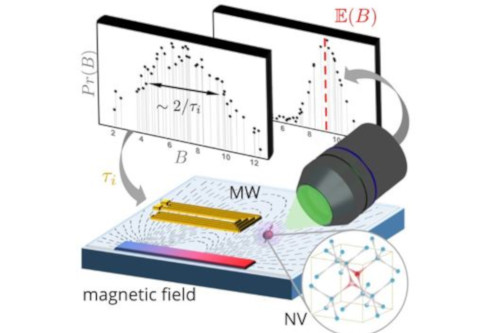

Машинное обучение прокладывает путь для квантового зондирования следующего уровня

Машинное обучение прокладывает путь для квантового зондирования следующего уровня

Шаги к новой специализированной системе создания медицинских устройств на основе искусственного интеллекта

Шаги к новой специализированной системе создания медицинских устройств на основе искусственного интеллекта

Робот BINA48 с ИИ посещает в колледже курсы о любви

Робот BINA48 с ИИ посещает в колледже курсы о любви

Обучение систем искусственного интеллекта для адаптации к динамическим средам

Обучение систем искусственного интеллекта для адаптации к динамическим средам

Использование ИИ для исследования космоса

Использование ИИ для исследования космоса

Отрасль поможет сделать электроэнергетики более экологичной ИИ

Отрасль поможет сделать электроэнергетики более экологичной ИИ