- Главная

- >

- Роботы с искусственным интеллектом

- >

- Эксперты ИИ и роботы убийцы

Эксперты ИИ и роботы убийцы

Протест KAIST

Президент престижного Корейского Института передовых наук и технологий (KAIST) отступает от планов по созданию военного оружия искусственного интеллекта (ИИ) в нарушение запретов Организации Объединенных Наций (ООН) после массового бойкота университета более чем 50 ведущими мировыми экспертами в области ИИ.

Сун Чхоль шин, который ранее подписал соглашение с оружейной компанией Hanwha Systems о разработке "разрушительного" оружия ИИ, известного как” кассетные боеприпасы", недавно объявил, что он отказывается от плана сотрудничества из-за давления со стороны лидеров отрасли, многие из которых говорят, что это действительно плохая идея, которая угрожает непрерывности человечества.

Поскольку оружие искусственного интеллекта может действовать самостоятельно без участия человека или контроля, оно представляет собой угрозу для планеты типа Терминатора, которая в конечном итоге может полностью уничтожить человеческую расу. Глава Tesla Илон Маск неоднократно предупреждал об этом, отмечая, что даже невоенный ИИ может уничтожить 95 процентов или больше человечества.

В своем письме о бойкоте, которое в конечном итоге убедило его изменить курс, 50 экспертов AI написали о своем разочаровании позицией KAIST по гонке вооружений AI.

” В то время, когда Организация Объединенных Наций обсуждает вопрос о том, как сдержать угрозу международной безопасности, создаваемую автономным оружием, достойно сожаления, что такой престижный институт, как КАИСТ, стремится ускорить гонку вооружений для разработки такого оружия", - заявили они.

“We therefore publicly declare that we will boycott all collaborations with any part of KAIST until such time as the President of KAIST provides assurances, which we have sought but not received, that the Center will not develop autonomous weapons lacking meaningful human control.”

Технологии ИИ являются античеловеческими и не могут распространяться

Имейте в виду, что KAIST в настоящее время является домом для ведущих мировых роботов и научных лабораторий, где все, от жидких батарей до датчиков заболеваний, в настоящее время находится в стадии разработки. Публичное осуждение экспертов в области ИИ, другого ведущего технологического фронта, не является чем-то, что школа хочет закрепить за своей репутацией, поэтому решение шин прекратить свое участие в разработке военного оружия ИИ.

“Это показывает силу научного сообщества, когда мы решаем высказаться - наше действие было успешным в одночасье", - заявил Тоби Уолш из Университета нового Южного Уэльса (UNSW) в Австралии.

"Я был очень рад, что президент KAIST согласился не разрабатывать смертоносное автономное оружие и следовать международным нормам, обеспечивая значимый человеческий контроль над любым оружием на основе ИИ, которое будет разработано.”

В своем заявлении в средствах массовой информации шин объяснил, что его учреждение очень высоко ценит “права человека и этические стандарты"."В результате он" не будет проводить никаких исследований, противоречащих человеческому достоинству, включая автономное оружие, не имеющее реального человеческого контроля.”

Однако если какое-либо другое учреждение или правительство успешно разработает автономное оружие, последствия будут не чем иным, как разрушительными. Многие называют такой сценарий "третьей революцией в войне", когда современное оружие ИИ, такое как ракеты, ракеты и бомбы, начинает запускаться самостоятельно, совершенно независимо от человеческого вклада.

Это будет массовый хаос, например. Это также, по-видимому, приведет к глобальному массовому терроризму со стороны” умных “роботов – ” ящик Пандоры " использования оружия, который, как только он будет открыт, никогда больше не будет закрыт и сдержан.

ООН уже запланировала встречу в Женеве, Швейцария, для обсуждения вопросов, связанных с летальными автономными оружейными системами, или законами, чтобы разработать больше стандартов для продвижения вперед. Многие разные люди и организации, от Красного Креста до самого Илона маска, призывают к строгим ограничениям или даже общим запретам на такие системы.

Похожие статьи:

Инженеры MIT разрабатывают «мозг на кристалле» для ИИ

Инженеры MIT разрабатывают «мозг на кристалле» для ИИ

Может помочь в обнаружении рака новый способ использования искусственного интеллекта

Может помочь в обнаружении рака новый способ использования искусственного интеллекта

Ученые-программисты разрабатывают ПО, чтобы увидеть будущее

Ученые-программисты разрабатывают ПО, чтобы увидеть будущее

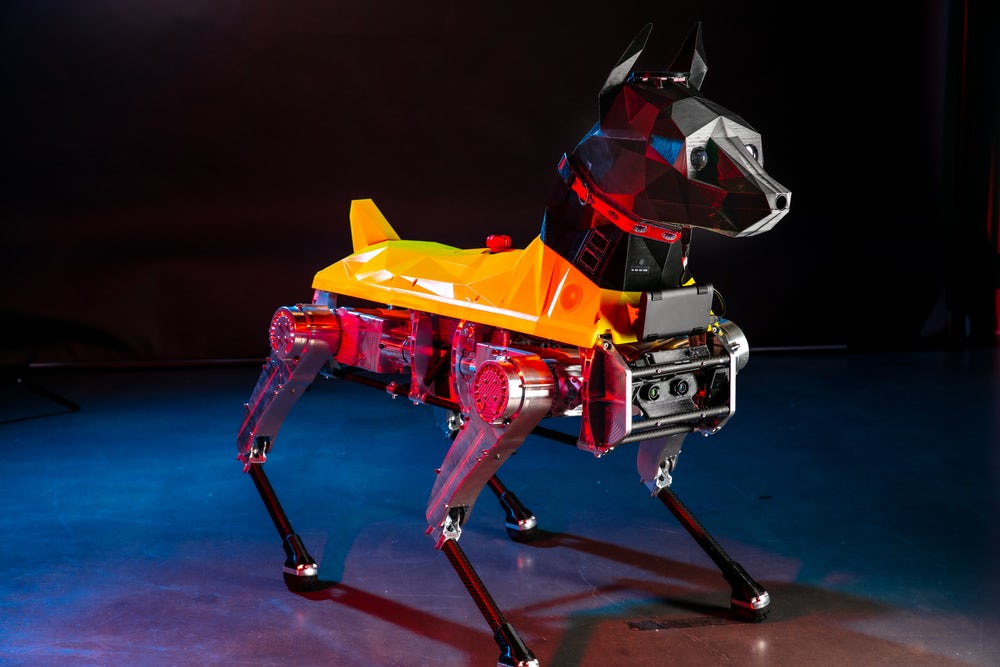

Лучший помощник с искусственным интеллектом – робот Astro

Лучший помощник с искусственным интеллектом – робот Astro

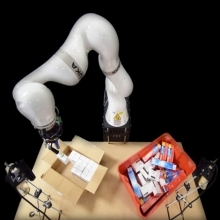

Контролирует роботизированную руку чтобы упаковывать коробки искусственный интеллект

Контролирует роботизированную руку чтобы упаковывать коробки искусственный интеллект

Техническая фирма Valuer ai использует ИИ для подбора стартапов

Техническая фирма Valuer ai использует ИИ для подбора стартапов