Эксперты ИИ требуют бойкота южнокорейского университета

Причины бойкота

В преддверии крупного совещания Организации Объединенных Наций по решению растущих проблем, связанных с летальным автономным оружием, команда ведущих исследователей ИИ и робототехники призвала к бойкоту южнокорейского университета, который недавно объявил об открытии лаборатории по искусству искусственного интеллекта.

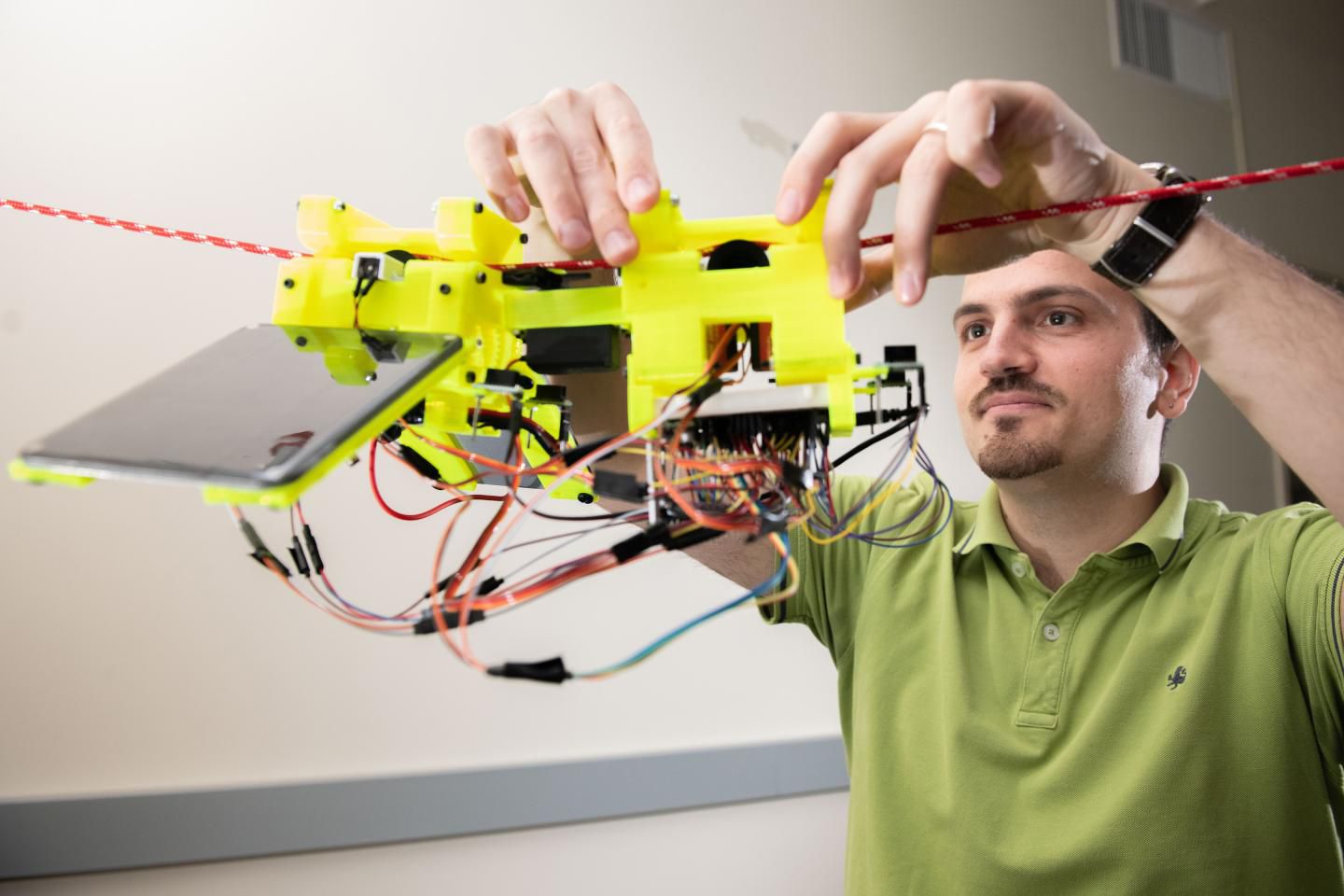

Еще в феврале ведущий правительственный университет Южной Кореи, KAIST (Корейский передовой институт науки и техники), объявил об открытии нового объекта под названием Исследовательский центр конвергенции национальной обороны и искусственного интеллекта. Объявление показало, что новый исследовательский центр будет исследовать различные военные системы на базе ИИ, включая автономные подводные транспортные средства и «системы управления и принятия решений на основе ИИ».

Объявление было воспринято с большой обеспокоенностью многими в исследовательском сообществе искусственного интеллекта, а недавно открытое открытое письмо, подписанное более чем 50 исследователями со всего мира, призывает к бойкоту всех академических совместных действий с KAIST по этому вопросу.

«В то время, когда Организация Объединенных Наций обсуждает вопрос о том, как сдерживать угрозу международной безопасности автономным оружием, вызывает сожаление тот факт, что престижный институт, такой как KAIST, стремится ускорить гонку вооружений для разработки такого оружия», - говорится в письме.

«Поэтому мы публично заявляем, что будем бойкотировать все сотрудничество с любой частью KAIST до тех пор, пока президент KAIST не предоставит заверения, которые мы искали, но не получили, что Центр не будет развивать автономное оружие, не имеющее значимого человеческого контроля. , например, не посещать KAIST, принимать посетителей из KAIST или участвовать в любом исследовательском проекте с участием KAIST ».

Бойкот был организован Тоби Уолшем (Toby Walsh), исследователем искусственного интеллекта из Университета Нового Южного Уэльса в Сиднее, который занимал видное место в разработке правил в отношении создания автономного оружия. Уолш ранее руководил крупными открытыми письмами в 2015 и 2017 годах, призывающими к запрету вооруженного искусственного интеллекта.

«Еще в 2015 году мы предупреждали о гонке вооружений в автономном вооружении», - говорит Уолш. «Эта гонка вооружений началась. Мы можем увидеть прототипы автономного оружия, которые сегодня разрабатываются многими странами, включая США, Китай, Россию и Великобританию».

Президент KAIST Сун-Чул Шин ответил на угрожаемый академический бойкот, опубликовав заявление, в котором отрицает, что учреждение работает над смертельными автономными системами оружия или «убийственными роботами».

«Центр нацелен на разработку алгоритмов эффективных логистических систем, системы беспилотной навигации [и] авиационной подготовки», - говорится в заявлении Шин. «KAIST будет нести ответственность за обучение исследователей и предоставление консультаций. Как академическое учреждение, мы высоко ценим права человека и этические стандарты. KAIST не будет проводить какую-либо исследовательскую деятельность, противостоящую человеческому достоинству, включая автономное оружие, не имеющее значимого человеческого контроля «.

Любопытно, что сайт KAIST удалил оригинальное объявление, опубликованное в конце февраля, в котором описывается открытие нового исследовательского центра.

Фраза «значимый человеческий контроль» представляется наиболее важной в этих текущих дискуссиях по регулированию. 9 апреля Группа правительственных экспертов Организации Объединенных Наций по системам смертоносных автономных вооружений вновь соберется на первое из двух заседаний, запланированных в этом году для изучения результатов политики, связанных с оружием AI. Предварительная повестка дня этих совещаний предполагает определение того, что на самом деле означает «значимый человеческий контроль», будет иметь основополагающее значение для любых будущих правовых положений.

Ответ России и США

В то время как 22 страны уже призвали к прямому, упреждающему запрету на развитие автономного оружия, несколько более крупных военных государств, похоже, задерживают любые действия. Россия, уже продемонстрировав свой прогресс в направлении создания автономного вооружения, прямо отказалась поддержать любой «превентивный запрет» по этому вопросу, и Соединенные Штаты разрабатывают свои собственные автономные оружейные программы. Без поддержки этих крупных военных держав трудно понять, что какое-либо будущее правительство Соединенных Штатов не будет чем-то символическим.

Похожие статьи:

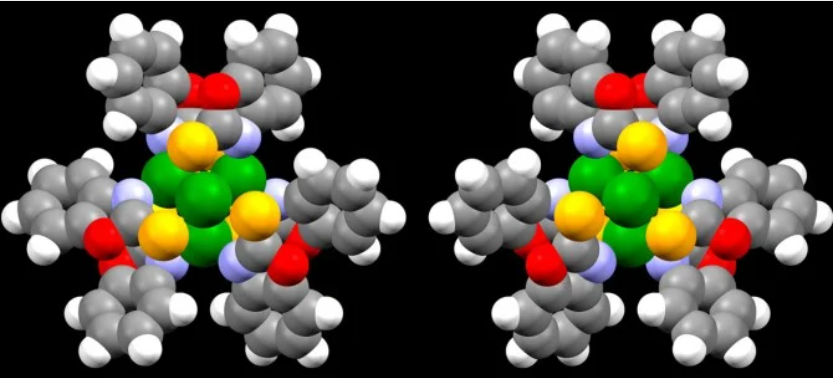

Нанокластеры имитирующие биомолекулы создают исследователи

Нанокластеры имитирующие биомолекулы создают исследователи

Благодаря технологии перевернутой 3D-печати можно создавать объекты из нескольких материалов

Благодаря технологии перевернутой 3D-печати можно создавать объекты из нескольких материалов

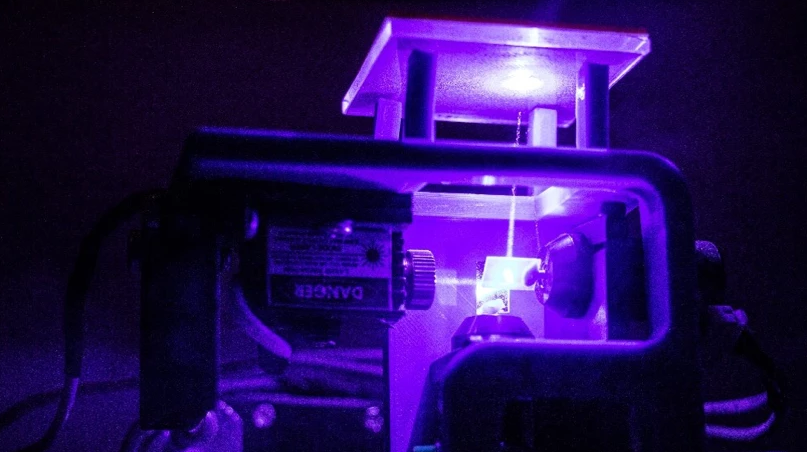

Ученые замедляют и направляют свет с помощью резонансных наноантенн

Ученые замедляют и направляют свет с помощью резонансных наноантенн

Специально медленно передвигается этот робот-ленивец Sloth Bot

Специально медленно передвигается этот робот-ленивец Sloth Bot

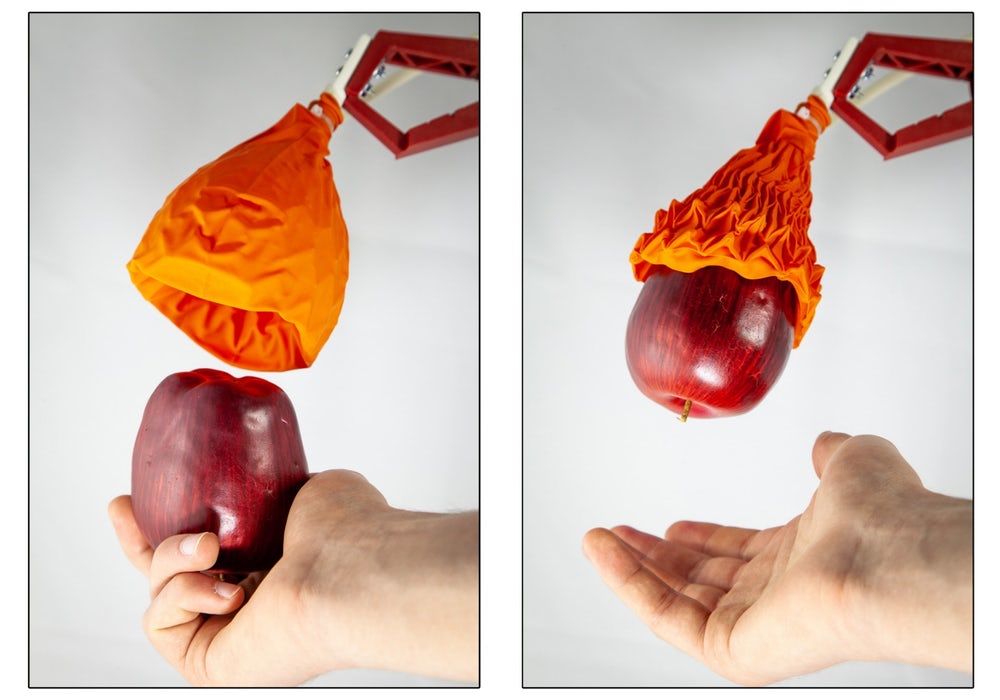

Новый роботизированный захват MIT Magic Ball работает как венерина мухоловка

Новый роботизированный захват MIT Magic Ball работает как венерина мухоловка

Для новых инновационных наушников кремниевая акустическая система

Для новых инновационных наушников кремниевая акустическая система