- Главная

- >

- Роботы с искусственным интеллектом

- >

- Умное обучение нейронных сетей

Умное обучение нейронных сетей

В наши дни почти все продукты на основе искусственного интеллекта в нашей жизни полагаются на «глубокие нейронные сети», которые автоматически учатся обрабатывать данные. Тем не менее, для большинства организаций и частных лиц глубокое обучение трудно обеспечить. Чтобы обучение было качественным, нейронные сети обычно должны быть достаточно большими и требовать массивных наборов данных.

Этот процесс обычно требует нескольких дней обучения и дорогостоящих графических процессоров (GPU), а иногда даже специально разработанного оборудования. Но что, если они на самом деле не должны быть такими большими?

Статься об улучшении обучения ИИ

В новой статье исследователи из Лаборатории компьютерных наук и искусственного интеллекта Массачусетского технологического института сообщили новости , что нейронные сети содержат подсети размером до одной десятой от основного размера, но при этом способны обучаться делать те же вещи - и иногда могут научиться делать так даже быстрее чем оригинал. Подход команды сейчас не особенно эффективен - они должны обучить и «разделить» всю сеть несколько раз, прежде чем найдут успешную подсеть.

Тем не менее, ассистент профессора MIT Майкл Карбин говорит, что результаты его команды показывают, что, если мы сможем точно определить, какая часть исходной сети имеет отношение к окончательному результату, ученые однажды смогут вообще пропустить этот дорогостоящий процесс. Такое открытие может сэкономить часы работы и упростить создание значимых моделей отдельными программистами, а не только огромными техническими компаниями.

«Если изначально сеть не должна была быть такой большой, почему вы не можете просто создать такую, которая имеет правильный размер в начале?» говорит студент Джонатан Франкл, который представил свою новую статью в соавторстве с Карбин на Международной конференции по обучению представительств (ICLR) в Новом Орлеане.

Проект был назван одной из двух лучших работ ICLR из примерно 1600 представленных. Команда сравнивает традиционные методы глубокого обучения с лотереей. Обучение крупных нейронных сетей - это все равно что пытаться гарантировать, что вы выиграете в лотерею, слепо покупая все возможные билеты. Но что, если бы мы могли выбрать выигрышные номера в самом начале?

Принцип работы

«С помощью традиционной нейронной сети вы случайным образом инициализируете эту большую структуру, и после обучения ее огромному количеству данных она волшебным образом работает», - говорит Карбин. «Эта большая структура похожа на покупку большого пакета билетов, хотя есть только небольшое количество билетов, которые действительно сделают вас богатыми.

Остальная часть работы - выяснить, как определить выигрышные билеты, не видя выигрышные номера». Работа команды также может иметь значение для так называемого «трансферного обучения», когда создаются сети, подготовленные для такой задачи, как распознавание изображений, чтобы затем помочь в решении совершенно другой задачи. Традиционное трансферное обучение включает в себя обучение сети, а затем добавление еще несколько функций, подготовленных для другой задачи.

Во многих случаях сеть, обученная для одной цели, может затем извлечь какие-то общие знания, которые впоследствии могут быть использованы для другой цели. Несмотря на огромный ажиотаж нейронных сетей, почти никто не занимается их разработкой из-за сложности обучения. Поскольку обучение может быть слишком дорогим, ученым, занимающимся данными, приходится идти на многие уступки, принимая во внимание ряд компромиссов в отношении размера модели, количества времени, необходимого для обучения, и ее конечных результатов.

Чтобы проверить их так называемую «гипотезу лотерейного билета» и продемонстрировать существование этих небольших подсетей, команде нужен был способ их найти. Они начали с использования общего подхода для устранения ненужных подключений из обученных сетей, чтобы их можно было устанавливать на устройства с низким энергопотреблением, такие как смартфоны - они «обрезали» подключения с наименьшим «весом».

Их ключевым нововведением была идея о том, что соединения, которые были обрезаны после обучения сети, вообще никогда не были нужны. Чтобы проверить эту гипотезу, они снова попытались обучить ту же самую сеть, но без сокращенных соединений. Важно то, что они «сбрасывают» каждое соединение на тот вес, который был ему назначен в начале тренировки. Эти начальные веса имеют важное значение для выигрыша лотерейных билетов: без них обрезанные сети не будут учиться.

Обрезая все больше и больше соединений, они определяли, сколько можно удалить, не нанося ущерба способности сети к обучению. Чтобы подтвердить эту гипотезу, они повторили этот процесс десятки тысяч раз во многих различных сетях в широком диапазоне условий. «Было удивительно видеть, что перезагрузка хорошо работающей сети часто приводит к чему-то лучшему», - говорит Карбин. «Это говорит о том, что все, что мы делали в первый раз, было не совсем оптимальным, и что есть возможность улучшить то, как эти модели учатся совершенствоваться».

В качестве следующего шага команда планирует выяснить, почему определенные подсети особенно хороши в обучении, и способы эффективного поиска этих подсетей. ««Понимание гипотезы лотерейного билета», вероятно, заставит ученых попотеть», - говорит Даниэль Рой, доцент кафедры статистики в университете Торонто, который не участвовал в работе.

«Работа также может иметь приложения для сжатия и оптимизации сети. Можем ли мы определить эту подсеть на раннем этапе обучения, что ускорит его? Могут ли эти методы использоваться для построения эффективных схем сжатия, заслуживает изучения».

Похожие статьи:

Обучение систем искусственного интеллекта для адаптации к динамическим средам

Обучение систем искусственного интеллекта для адаптации к динамическим средам

Система ИИ берет бразды правления над своенравными дронами

Система ИИ берет бразды правления над своенравными дронами

Samsung будут иметь ИИ Exynos 9820 в 2019 году

Samsung будут иметь ИИ Exynos 9820 в 2019 году

Применение в прогнозировании погоды машинного обучения

Применение в прогнозировании погоды машинного обучения

ИИ Baidu может выполнять синхронный перевод между любыми языками

ИИ Baidu может выполнять синхронный перевод между любыми языками

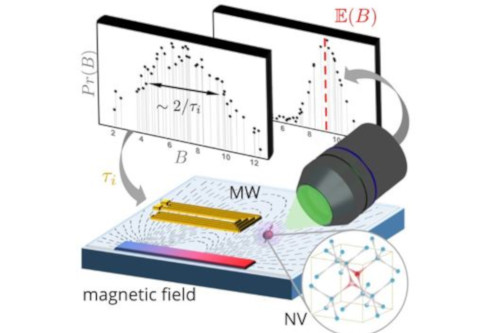

Машинное обучение прокладывает путь для квантового зондирования следующего уровня

Машинное обучение прокладывает путь для квантового зондирования следующего уровня