Трансформация больших объёмов данных в нужную информацию - новый метод Sandia

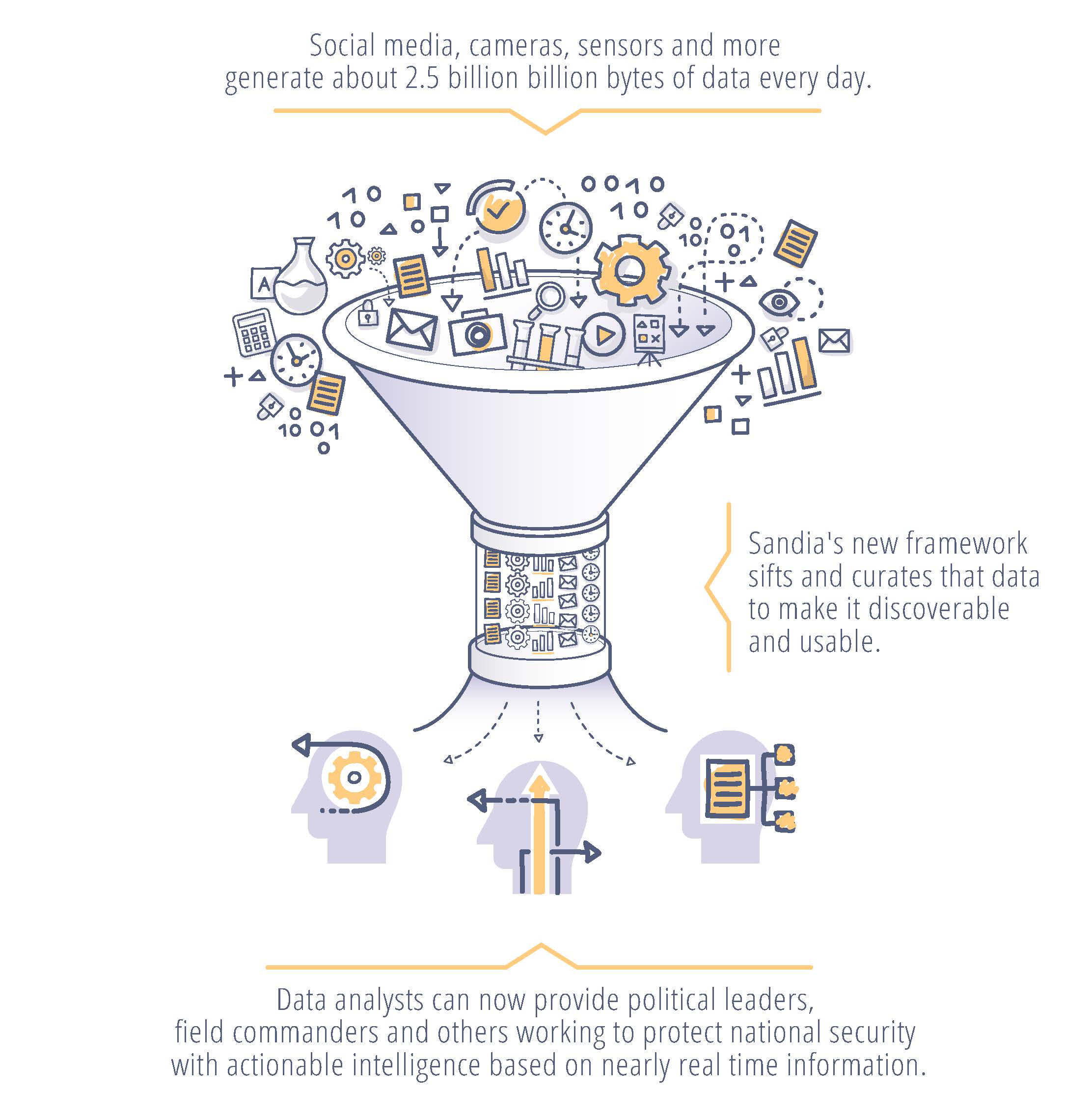

Социальные сети, камеры, датчики и многое другое генерируют огромные объемы данных, которые могут ошеломить аналитиков, перебирающих все это для получения значимой и действенной информации, чтобы предоставить лицам, принимающим важные решения, таким как политические лидеры и люди, отвечающие на угрозы безопасности. «Объем данных, создаваемых датчиками и социальными сетями очень быстро растет - каждый день генерируется около 2,5 квинтиллионов (или 2,5 миллиардов) байтов данных», - говорит Тиан Ма, научный сотрудник Sandia и со-руководитель проекта.

«Около 90% всех данных было сгенерировано за последние два года - данных больше, чем людей, которые их анализируют. Разведывательные сообщества в основном перегружены, и проблема в том, что в результате может остаться очень много незамеченных, но важных данных». Исследователи из Национальной лаборатории Sandia работают над тем, чтобы уменьшить эту нагрузку, развивая науку, чтобы получать информацию из данных сразу после их поступления.

Исследователи из Sandia вместе со студентами Университета Иллинойса, Урбана-Шампейн, партнера Академического альянса, разработали аналитические алгоритмы и алгоритмы принятия решений для потоковой передачи источников данных и интегрировали их в среду распределенной их обработки практически в реальном времени, используя инструменты для обработки больших объёмов информации и вычисления. Платформа берет разрозненные данные из нескольких источников и генерирует полезную информацию, которая может использоваться сразу же.

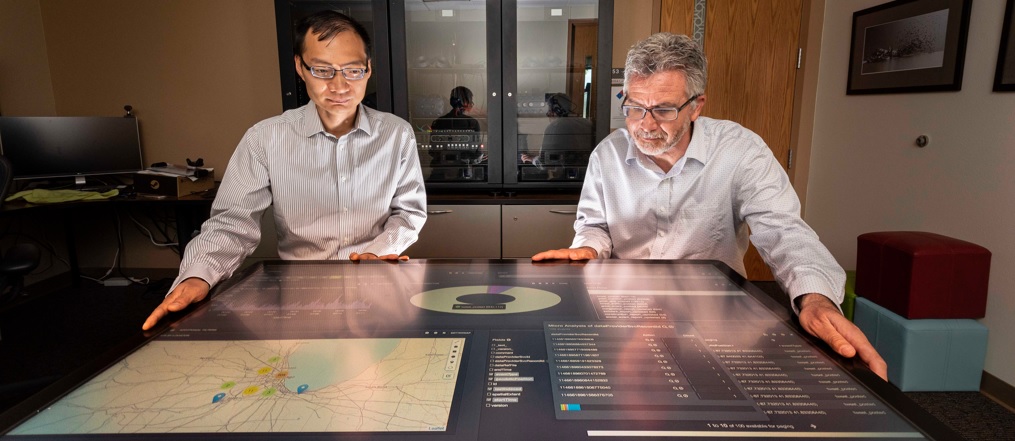

Чтобы проверить систему, исследователи и студенты использовали данные о дорожном движении Чикаго - изображения, информации с датчиков, твиты и потоковый текст, чтобы успешно измерить пробки на дорогах и предложить более быстрые маршруты для объезда. Исследовательская группа выбрала пример трафика в Чикаго, потому что введенные данные имеют характеристики, сходные с данными, обычно наблюдаемыми в целях национальной безопасности, сказал Руди Гарсиа, ученый и один из руководителей проекта.

Данных слишком много

«Мы создаем данные, даже не задумываясь об этом», - сказала Лаура Патрици, научный сотрудник Sandia и член исследовательской группы, во время выступления на симпозиуме GEOINT Фонда геопространственной разведки США в 2019 году. «Когда мы ходим с нашим телефоном в кармане или пишем в Твиттере об ужасном трафике, наш телефон отслеживает наше местоположение и может привязывать геолокацию к нашему твиту».

Чтобы использовать эту лавину данных, аналитики обычно используют инструменты для работы с большими объёмами данными и алгоритмы машинного обучения, чтобы находить и выделять важную информацию, но процесс выполняется на данных, которые могли быть записаны давно, говорит Ма. «Мы хотим извлекать информацию из новых и актуальных данных, а не использовать возможно уже устаревшую информацию», - сказал Ма. «Актуальный интеллект - это следующий уровень анализа данных, где анализ используется для принятия решений практически в реальном времени. Успех этого исследования окажет сильное влияние на многие критические по времени приложения национальной безопасности».

Построение структуры обработки данных

Команда объединила распределенные технологии в серию конвейеров обработки данных, которые принимают, курируют и индексируют данные. Ученые, обсуждая данные, указали, как они должны собираться и очищаться. Платформа данных Hortonworks, работающая на компьютерах Sandia, использовалась в качестве программной инфраструктуры для обработки данных и аналитических конвейеров.

В рамках Hortonworks команда разработала и интегрировала топологии Apache Storm для каждого конвейера данных. Затем отобранные данные были сохранены в Apache Solr, поисковой системе предприятия и базе данных. По словам Гарсии, Py Torch и Lucidwork Banana использовались для обнаружения объектов транспортных средств и визуализации данных. «Каждый тип данных, который мы принимаем, имеет свою собственную схему и формат данных», - сказал Гарсия. «Для того, чтобы данные были полезны, их нужно сначала курировать, чтобы их можно было легко обнаружить при необходимости».

Как находить правильные данные?

«Вводить большие объемы данных сложно, но еще сложнее найти информацию, которая вам действительно нужна», - сказал Гарсия. «К примеру, во время тестирования проекта мы увидели твиты, в которых говорилось что-то вроде: «Управление воздушным движением держало нас на земле в течение последнего часа на Мидуэй». Этот твит о трафике, но он не имеет никакого отношения к автостраде».

Чтобы определить уровень заторов на автостраде в Чикаго, в идеале инструмент мог бы использовать различные типы данных, включая дорожную камеру, показывающую поток в обоих направлениях, твиты с геолокацией об авариях, дорожные датчики, измеряющие среднюю скорость, спутниковые снимки областей и Дорожные знаки, сказал Форест Дэнфорд, ученый и член исследовательской группы.

«Тем не менее, мы также получаем много некачественных данных, таких как изображения с веб-камеры, которые трудно разобрать, и редко мы получаем много разных типов данных, которые очень тесно связаны во времени и пространстве», - сказал Дэнфорд. «Нам нужен был механизм для изучения более чем 90 миллионов событий, и чаще всего ИИ приходилось делать выводы на основе неполной информации».

Команда добавила классификатор пробок на дорогах, обучив объединенные компьютерные системы, работающие по принципу человеческого мозга, функциям, извлеченным из помеченных изображений и твитов, и другим событиям, которые соответствуют данным во времени и пространстве. По словам Дэнфорда, обученный классификатор смог генерировать прогнозы о пробках на основе оперативных данных в любой момент времени и в любом месте.

Профессора Минь До, Рамаварапу Сринивас и их студенты в UIUC работали над распознаванием объектов и изображений в режиме реального времени с помощью изображений с веб-камеры и разработали надежные процессы планирования маршрутов, основанные на различных источниках данных. «Развитие убедительной науки для действенного интеллекта требует от нас борьбы с информационной динамикой», - сказал Сринивас.

«Мы словно нашли Святой Грааль. Нам нужно понять, чего именно мы хотим достичь, прежде чем реализовывать. Это намного сложнее, чем кажется, и этот проект - первый шаг к пониманию того, что именно мы хотим получить». Двигаясь вперед, команда Sandia передает архитектуру, аналитику и уроки, полученные в Чикаго, другим правительственным проектам и будет продолжать исследовать аналитические инструменты, улучшать модель распознавания объектов и работать над созданием значимого, действенного интеллекта.

«Мы пытаемся сделать данные обнаруживаемыми, доступными и пригодными для использования», - сказал Гарсия. «И если мы сможем сделать это с помощью этих больших архитектур данных, то я считаю, что в какой-то степени мы помогли человечеству».

Похожие статьи:

Исследователи создали реконфигурируемого робота из самораскрывающихся материалов киригами

Исследователи создали реконфигурируемого робота из самораскрывающихся материалов киригами

Новый исследовательский робот – Movo

Новый исследовательский робот – Movo

BigRep напечатали Loci - автономный электрический автомобиль

BigRep напечатали Loci - автономный электрический автомобиль

Cпособен отбуксировать трехтонный самолет четырехногий робот HyQ Real

Cпособен отбуксировать трехтонный самолет четырехногий робот HyQ Real

WowWee показывает новые роботизированные игрушки с ИИ на CES

WowWee показывает новые роботизированные игрушки с ИИ на CES

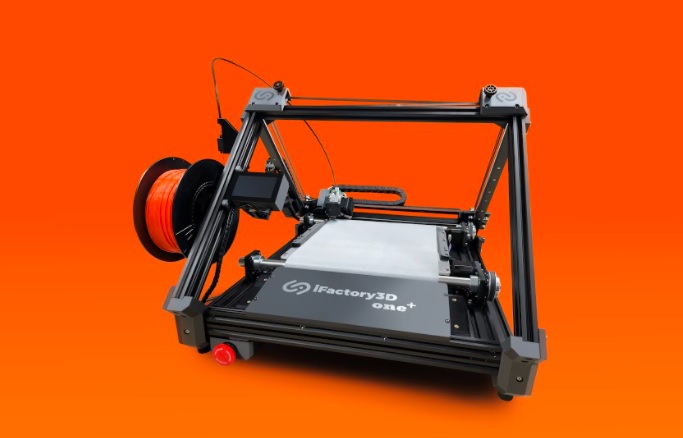

iFactory One Plus – новая концепция ленточного 3D-принтера

iFactory One Plus – новая концепция ленточного 3D-принтера