Позволяет редактировать текст выступающего в видео новый алгоритм Deepfake

Теперь можно снимать видео в стиле говорящей головы и добавлять, удалять или редактировать слова говорящего так же просто, как редактировать текст в текстовом редакторе. Есть новость , что новый алгоритм Deepfake может обработать аудио и видео в новый файл, в котором выступающий говорит более или менее так, как вы хотите.

Это совместная работа команды из Стэнфордского университета, Института информатики Макса Планка, Принстонского университета и Adobe Research, которые говорят, что в идеальном мире технология будет использоваться для сокращения дорогих повторных съемок, когда актер делает что-то не так, или сцена должна быть изменена.

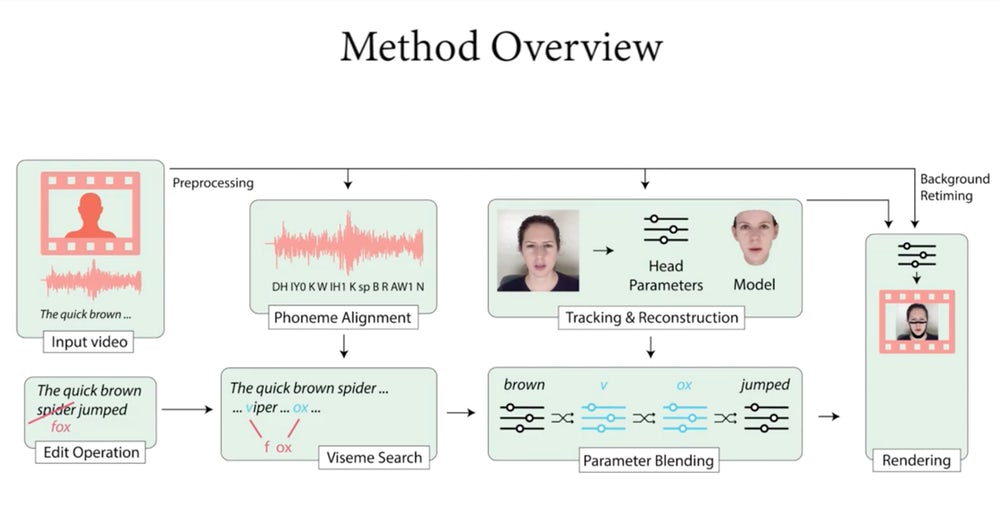

Работа алгоритма

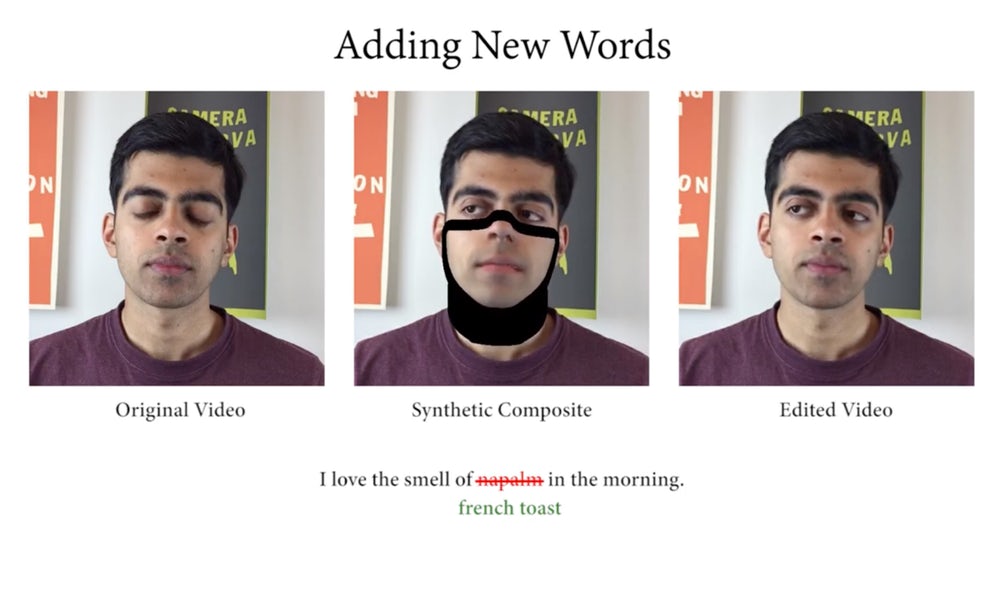

Для того, чтобы изучить движения лица говорящего, алгоритму требуется около 40 минут обучающего видео и стенограммы того, что говорится, так что это не то, что можно бросить в короткий фрагмент видео и запустить, если вы хотите хороших результатов. Эти 40 минут видео дают алгоритму возможность точно определить, какие формы лица делает объект для каждого фонетического слога в оригинальном сценарии.

После того, как вы отредактируете сценарий, алгоритм может создать трехмерную модель лица, добавляя новые необходимые сцены. И оттуда, технология машинного обучения, называемая Neural Rendering, может закрасить трехмерную модель фотореалистичными текстурами, чтобы она выглядела практически неотличимой от реальной.

Можно использовать другое программное обеспечение, такое как VoCo, если вы хотите генерировать аудио и видео говорящего, и он использует тот же подход, разбивая кучу обучающих аудио на фонемы, а затем используя этот набор данных для генерации новых слов в знакомом голос.

Проблемы использования

Команда осознает потенциал своего программного обеспечения для неэтичного использования. Мир еще не пострадал от своего первого крупного фальшивого скандала - возможно, мы увидим, что фальшивые видео станут частью поля битвы на выборах в США в 2020 году - но легко представить, что они являются невероятно эффективными инструментами обмана перед необразованной аудиторией.

Еще более тревожно осознавать, что их простое существование позволит нечестным общественным деятелям отрицать или подвергать сомнению подлинные видеоролики, которые показывают их в плохом свете. Как только пара глубоких фальшивых скандалов приличного размера пройдет мимо редакторов на CNN и будет разоблачена, мы вступим в эпоху, когда люди не могут, или, более того, не будут доверять тому, что видели в любом формате видео.

Исследовательская группа, стоящая за этим программным обеспечением, делает несколько слабых попыток справиться с его потенциальным неправильным использованием, предлагая решение, в котором любой, кто использует программное обеспечение, может опционально пометить его как фальшивку и предоставить «полный список правок». Это, очевидно, не является препятствием для злоупотребления.

Команда также предполагает, что другие исследователи разрабатывают «лучшие методы судебной экспертизы, такие как цифровые или не цифровые методы снятия отпечатков пальцев, чтобы определить, манипулировали ли видео для скрытых целей». Действительно, здесь есть некоторый потенциал для использования постоянных записей в стиле блокчейна, что позволило бы сравнить любой фрагмент видео с изначальным.

Но этого пока нет, и неясно, как это можно реализовать в глобальном масштабе. Что касается отсутствия доказательств фальшивости видео, многие, если не большинство приложений глубокого обучения уже работают над проблемой того, как обнаружить подделки. Действительно, при использовании подхода «Генеративная состязательная сеть» две сети конкурируют друг с другом - одна создает ложные данные, а другая пытается извлечь ложные данные из реальных данных.

На протяжении миллионов поколений проницательная сеть лучше выбирает фальшивки, и чем лучше она становится, тем лучше должна стать сеть, создающая фальшивку, чтобы обмануть ее. Таким образом, чем лучше эти системы автоматически обнаруживают фальшивые видео, тем лучше становятся фальшивки. Таким образом, CNN не смогут полагаться на простой алгоритм, который позволяет им автоматически сканировать входящее видео в поисках подделок.

Это сложная и серьезная проблема, и практически гарантированно окажет серьезное влияние на репортажи новостей в ближайшие десятилетия, даже если она сейчас находится в зачаточном состоянии. Видео ниже показывает, как легко редактировать видео, используя новый алгоритм.

Похожие статьи:

Разработку прототипа AR очков завершает BAE Systems

Разработку прототипа AR очков завершает BAE Systems

3D-принтеры от iFactory3D

3D-принтеры от iFactory3D

Платформа MPA создает профессиональное аудио оборудование которое похоже на Lego

Платформа MPA создает профессиональное аудио оборудование которое похоже на Lego

Самый большой скачок поколений к концу наступающего 2020 года обещает новый Xbox

Самый большой скачок поколений к концу наступающего 2020 года обещает новый Xbox

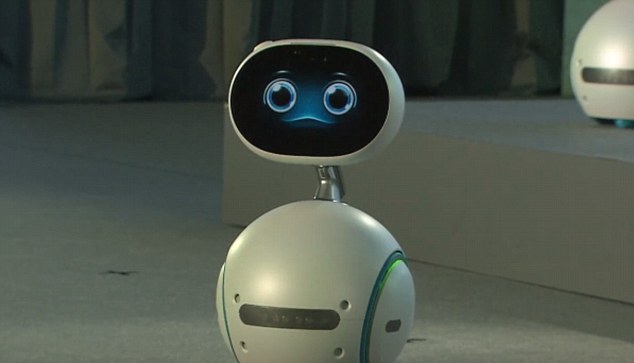

Zenbo Home Robot отправляется в продажу 1 января в Тайване

Zenbo Home Robot отправляется в продажу 1 января в Тайване

Могут спасти жизни людей датчики управляемые искусственным интеллектом

Могут спасти жизни людей датчики управляемые искусственным интеллектом