Роботы учатся говорить на языке тела

Если ваша подруга говорит, что чувствует себя расслабленной, но вы видите, что ее кулаки сжаты, вы можете усомниться в ее искренности. С другой стороны, роботы могут поверить ей на слово. Язык тела говорит много, но даже с достижениями в области компьютерного зрения и технологии распознавания лица, роботы изо всех сил пытаются заметить тонкое движение тела и могут пропустить важные социальные сигналы.

Если ваша подруга говорит, что чувствует себя расслабленной, но вы видите, что ее кулаки сжаты, вы можете усомниться в ее искренности. С другой стороны, роботы могут поверить ей на слово. Язык тела говорит много, но даже с достижениями в области компьютерного зрения и технологии распознавания лица, роботы изо всех сил пытаются заметить тонкое движение тела и могут пропустить важные социальные сигналы.

Где и как все началось

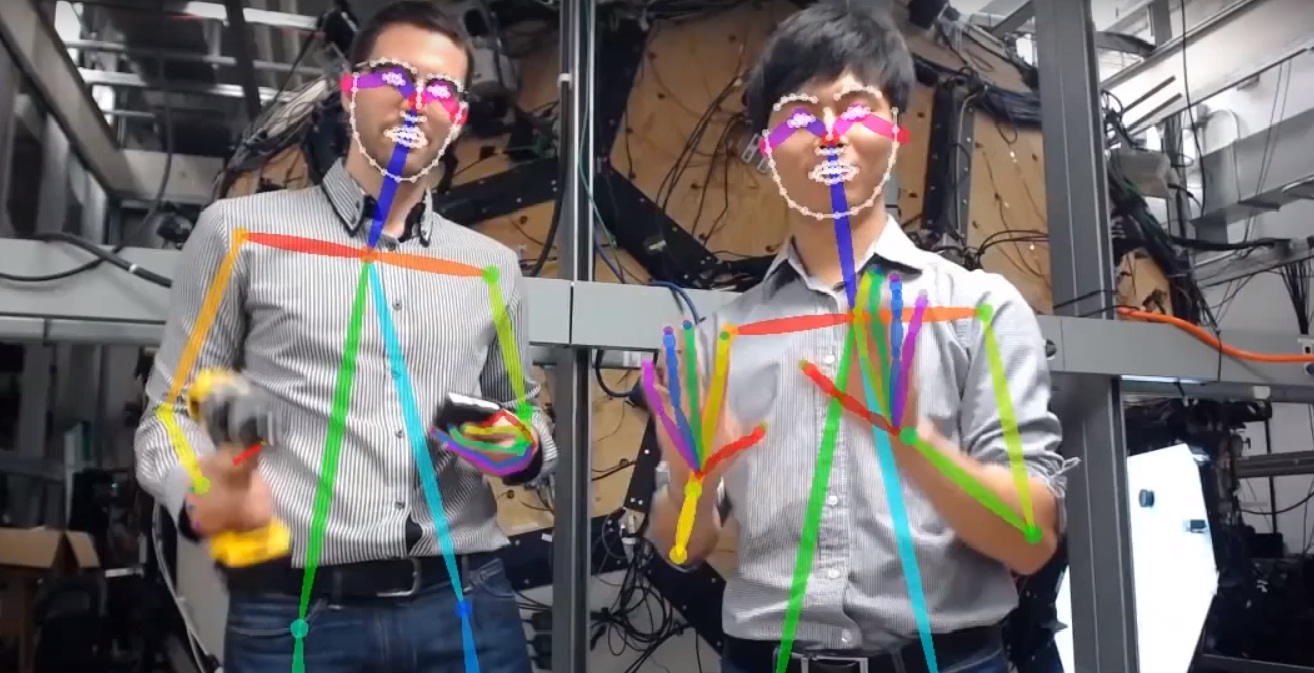

Исследователи из Университета Карнеги-Меллона разработали систему слежения за телом, которая может помочь решить эту проблему. Называется OpenPose, система может отслеживать движение тела, в том числе рук и лица, в режиме реального времени. Она использует компьютерное зрение и машинное обучение для обработки видеокадров и может даже отслеживать нескольких людей одновременно. Эта возможность может облегчить взаимодействие человека и робота и проложить путь для более интерактивной виртуальной и дополненной реальности, а также интуитивно понятных пользовательских интерфейсов.

Одна примечательная особенность системы OpenPose заключается в том, что она может отслеживать не только голову, туловище и конечности человека, но и отдельные пальцы. Для этого исследователи использовали Паноптическую студию CMU, купол с 500 камерами, где они фиксировали позы тела под разными углами, а затем использовали эти изображения для создания набора данных.

Как это устроено

Затем они передали эти изображения через так называемый детектор ключевых точек для идентификации и маркировки определенных частей тела. Программное обеспечение также учится связывать части тела с людьми, так что он знает, например, что рука конкретного человека всегда будет близко к ее или его телу. Это дает возможность отслеживать сразу нескольких людей.

Изображения с купола были сняты в 2D. Но исследователи взяли обнаруженные ключевые точки и триангулировали их в 3D, чтобы помочь своим алгоритмам отслеживания тела понять, как каждая поза выглядит с разных точек зрения. При обработке всех этих данных система может определить, как выглядит вся рука, когда она находится в определенном положении, даже если некоторые пальцы скрыты.

Теперь система это набор данных, и он может работать только с одной камерой и ноутбуком. Он больше не требует, чтобы был купол, который определяет представления тела, делая технологию подвижной и доступным. Исследователи уже выпустили свой код для общественности, чтобы поощрять эксперименты.

Они говорят, что эта технология может быть применена ко всем видам взаимодействий между людьми и машинами. Он смог сыграть огромную роль в опытах ВР, позволяющ более точному обнаружению движения потребителя физического без любого дополнительного оборудования, как ручк-на датчиках или перчатках.

Это также может облегчить более естественные взаимодействия с домашним роботом. Вы могли бы сказать своему роботу "поднять это", и он мог бы сразу понять, на что вы указываете. Воспринимая и интерпретируя ваши физические жесты, робот может даже научиться читать эмоции, отслеживая язык тела. Поэтому, когда вы тихо плачете с лицом в руках, потому что робот взял вашу работу, он может предложить вам ткань.

Похожие статьи:

Эффективному формированию зрительных воспоминаний может помешать виртуальная реальность

Эффективному формированию зрительных воспоминаний может помешать виртуальная реальность

Робот демонстрирует повадки древних животных

Робот демонстрирует повадки древних животных

Jibo Social Robot продается за $ 899

Jibo Social Robot продается за $ 899

Новый компонент для создания проводов – наноленты из металлизированного графена

Новый компонент для создания проводов – наноленты из металлизированного графена

Обучение веб-дизайну: востребованность и плюсы профессии

Обучение веб-дизайну: востребованность и плюсы профессии

Может сканировать морское дно подводный робот SENTINEL

Может сканировать морское дно подводный робот SENTINEL